爬虫怎么解决封IP的问题?

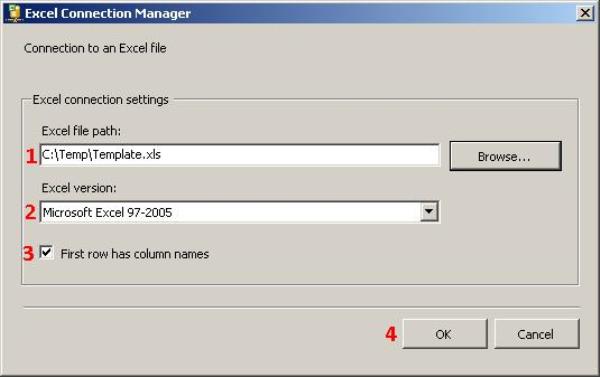

1、暂停爬取 暂停您的爬取程序一段时间(例如数小时或数天)使其充分休息,然后逐渐递减并调整下次访问时的间隔时间。更换 IP 更换爬取程序所在的 IP 地址,例如使用代理 IP 或者 VPN把请求转发到其他地址上。

2、,使用代理IP:代理IP是一种将您的请求通过第三方服务器发送的方法。通过使用不同的代理IP,您可以模拟不同的来源IP地址,以绕过IP限制。有一些免费或付费的代理IP服务提供商,您可以从中获取代理IP列表。

3、放慢爬取速度,减小对于目标网站造成的压力。但是这样会减少单位时间类的爬取量。第二种方法是通过设置IP等手段,突破反爬虫机制继续高频率爬取。

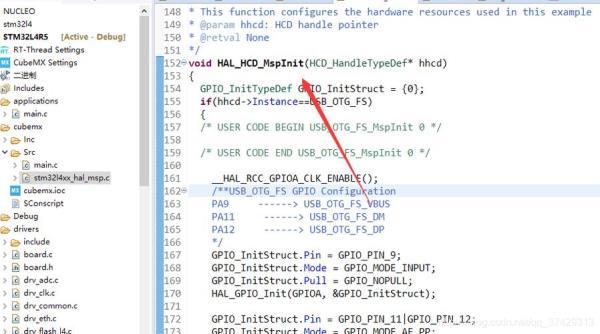

4、爬虫伪装浏览器点击 我们先理解一下网站的代码执行,首先我们向服务器发送请求,这时服务器的后台php、java都会执行,然后网站代码被发送到本地,在本地时js、ajax会在浏览器内核中执行。

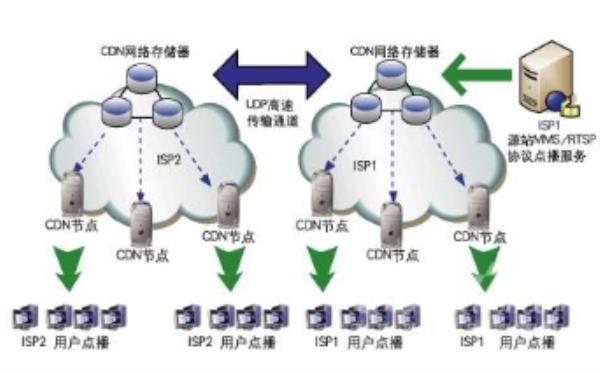

搜索引擎蜘蛛工作原理?

而蜘蛛池程序的原理,就是将进入变量模板生成大量的网页内容,从而吸大批的蜘蛛,让其不停地在这些页面中抓取,而将我们需要收录的URL添加在蜘蛛站开发的一个特定版块中。

蜘蛛喜欢的行为一:网站和页面的权重尽可能的高,蜘蛛抓取的过程中首先考虑这种网站,因为在蜘蛛看来,质量高、建站时间长的网站才会有比较高的权重。高权重的网站甚至可以达到秒收录的效果。

蜘蛛其实就是搜索引擎的手下,搜索引擎命令它到互联网上浏览网页,从而得到互联网的所有数据,然后把这些数据存到搜索引擎自己的数据库中。当然了,这个数据库是相当强大的。

如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来,被抓取的网页被称之为网页快照。数据库处理 搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。

使用户能在百度搜索引擎中搜索到您网站的网页、图片、视频等内容。百度蜘蛛的运行原理。

爬虫使用代理IP为何成功率不能达到100%?

网络爬虫是自动获取内容的程序,抓取数据很方便。但爬虫对被爬取的网站没有任何好处,所以就有了反爬虫,反爬虫主要对IP进行限制。

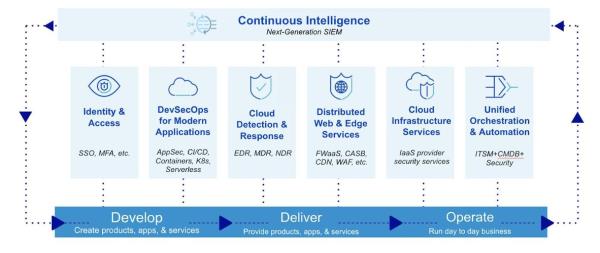

爬虫代理池是一种用于优化网络爬虫效率的工具,其主要作用是管理一组代理IP地址,使得网络爬虫可以在访问目标网站时自动切换使用不同的代理IP地址,从而避免被目标网站封禁或限制访问。

如果出现403forbidden或者页面无法打开的问题,那么就很有可能是IP已经被站点服务器所封禁,遇到这种情况就需要更换自己的IP地址,目前来说最为方便的就是使用代理IP,例如IPIDEA,可以随时更换新的IP地址来确保爬虫的工作效率。

这个是属于使用该代理IP的人群太多造成的,而爬虫是需要动态IP才可以的,动态变化IP才能解决爬虫ip问题,其IP海动态ip解决IP更换问题。

高匿名代理IP可以完全隐藏用户的IP及信息,让目标网站不会有丝毫的察觉,无论是用来做什么工作都可以放心使用。多线程爬取,多线程是为了同步完成多项任务,通过提高资源使用效率来提高系统的效率。

限制IP等。验证码。可以利用打码平台破解(如果硬上的话用opencv或keras训练图);登陆。利用requests的post或者selenium模拟用户进行模拟登陆;限制IP。使用代理IP,因免费IP效果非常差,所以建议选择收费代理IP。

以上就是爬虫ip池原理(爬虫ip代理池设计)的内容,你可能还会喜欢爬虫ip池原理,爬虫使用代理,爬虫ip代理池,爬虫代理,ip代理池等相关信息。