- 1、使用scrapy爬虫设置了ip代理报错是怎么回事

- 2、爬虫代理池(优化你的网络爬虫效率)

- 3、爬虫一般采用什么代理ip

- 4、python爬虫应该怎样使用代理IP

- 5、为什么爬虫需要代理ip?

- 6、如何用爬虫爬网络代理服务器地址

使用scrapy爬虫设置了ip代理报错是怎么回事

一些用户在运用Scrapy爬虫时,遇到了即便配置了IP代理,仍然无法成功发送请求的问题。这种情况出现的原因可能是爬虫的使用方法不正确,或者所选用的代理IP质量不佳。遇到此类问题,可以采取以下几种解决办法: 降低爬取速度:减少对目标网站的访问压力,这样可以减少单位时间内的爬取量。

一些网站为了控制流量和防止受到攻击,通常会设置单IP在一分钟内允许的最大请求数。 您在网上找到的利用IP代理来解决IP受限的问题的方法,在大多数情况下确实是有效的。 之所以说在大多数情况下有效,是因为您使用IP代理发出的HTTP请求实际上已经被黑客广泛使用。

放慢爬取速度,减少对于目标网站带来的压力,但会减少单位时间类的爬取量。测试出网站设置的限制速度阈值,设置合理的访问速度。

CloseSpider的异常。但是如scrapy官网提到的,Scrapy默认的设置是过滤掉有问题的HTTP response(即response状态码不在200-300之间)。

那么只能通过多外部IP的方式来实现了。方法6 对爬虫抓取进行压力控制;可以考虑使用代理的方式访问目标站点。降低抓取频率,时间设置长一些,访问时间采用随机数。频繁切换UserAgent(模拟浏览器访问)。多页面数据,随机访问然后抓取数据。更换用户IP,这是最直接有效的方法。

爬虫代理池(优化你的网络爬虫效率)

爬虫代理池是一种用于优化网络爬虫效率的工具,其主要作用是管理一组代理IP地址,使得网络爬虫可以在访问目标网站时自动切换使用不同的代理IP地址,从而避免被目标网站封禁或限制访问。为什么需要使用爬虫代理池?在进行网络爬虫时,我们经常会遇到一些问题,如目标网站的反爬虫策略、访问频率限制等。

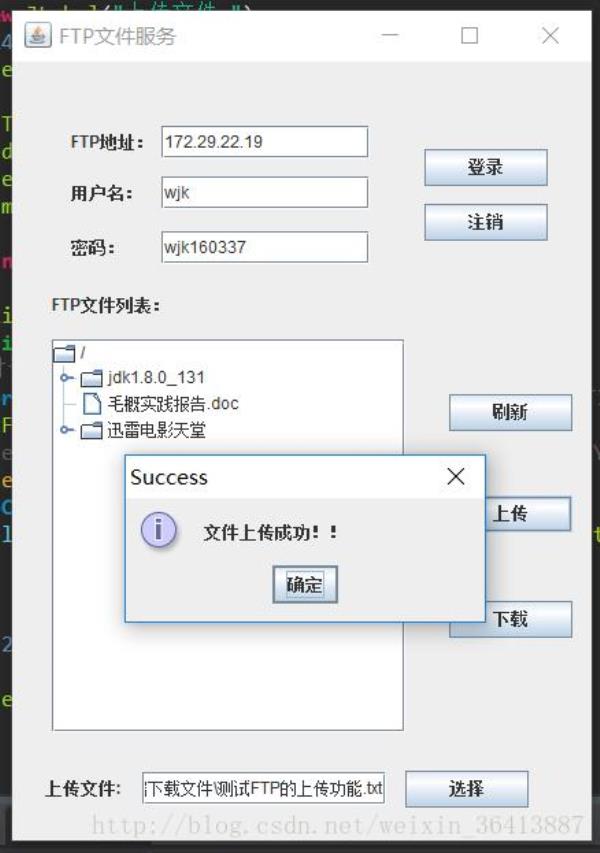

设计代理IP池的目的是为了方便管理和提高工作效率,特别是在进行网络爬虫操作时。 代理IP的获取可以通过两种方式:免费代理IP可以使用ProxyGetter接口从代理源网站抓取;而付费代理IP通常通过专门的API获取,注意API的使用限制,如提取数量和间隔时间。 存储代理IP时,推荐使用SSDB数据库。

代理IP池外部接口除代理拨号服务器获取的代理IP池,还需要设计一个外部接口,通过这个接口调用IP池里的IP给爬虫使用。代理IP池功能比较简单,使用Flask就可以搞定。功能可以是给爬虫提供get/delete/refresh等接口,方便爬虫直接使用。

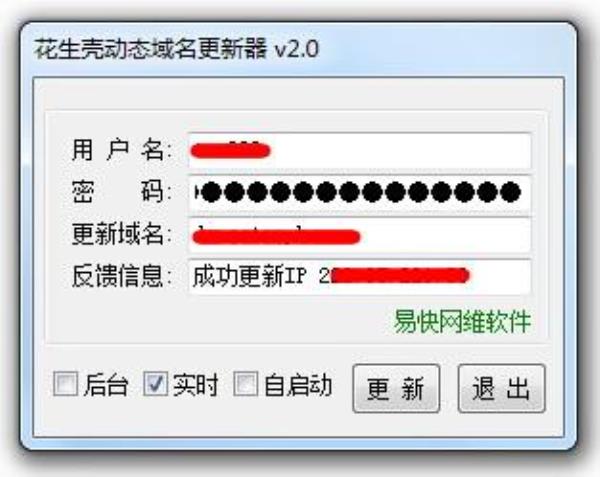

第一步:找IP资源 IP资源并不丰富,换句话说是供不应求的,因此一般是使用动态IP。免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。付费方法,通过购买芝麻ip上的IP资源,并进行提取,搭建IP池。第二步,检测可用IP保存。

Manager,get/delete/refresh/get_all等接口的具体实现类,目前代理池只负责管理proxy,日后可能会有更多功能,比如代理和爬虫的绑定,代理和账号的绑定等等。其他文件,配置文件:Config.ini,数据库配置和代理获取接口配置,可以在GetFreeProxy中添加新的代理获取方法,并在Config.ini中注册即可使用。

爬虫代理是爬虫过程中不可或缺的要素。当你爬取的数据达到一定量后,你会发现程序会时不时给你报错,而且频率越来越来高。这说你的爬虫被人家识别出来了,对方的反扒系统已经记住了你。通常会告诉你连接超时、连接中断更有甚者会直接中断你程序。

爬虫一般采用什么代理ip

在实际应用中,爬虫使用的代理IP可以分为免费代理IP和付费代理IP两种。免费代理IP一般从公开的代理服务器列表中获取,这些服务器由志愿者提供,稳定性较差,且容易被滥用。付费代理IP则由专业机构提供,稳定性、可用性较高,但需要一定的成本支出。

高匿性。这个算是基本要求了,付费的代理IP如果不是高匿名的就太不值了。真实IP。真实IP的有效率,业务成功率都是遥遥领先的。

什么样的IP的代理的话可以用来做那种爬虫的采集,你要选择的话肯定就是根据那个性质的决定来改变的。

python爬虫ip代理,超多IP,质量很高,使用中很稳定,IP连通率也极高。一手率IP资源池:巨量HTTP代理IP池,均通过自营机房机柜托管,当前全国部署200+城市,每日稳定产出千万ip池,对于IP的纯净度、使用率更有保障。

透明代理(Transparent Proxy)透明代理虽然可以直接“隐藏”客户端的 IP 地址,但是还是可以从来源查到客户端的 IP地址。普通匿名代理(Anonymous Proxy)普通匿名代理能提供隐藏客户端IP地址的功能,但当用户使用普通匿名代理时,服务器就能知道客户端使用代理的行为。

网络中真真正正能用的免费代理ip总数并没有很多,不能满足分布式爬虫对于代理IP的大量需求。IP不稳定:免费代理ip没有专业人员维护,而且任何一个人都能够使用,当然影响IP连接效果。隐匿性不高:隐匿性指能够隐藏真实IP地址的成都,隐匿性越高,安全性越高。而免费代理ip在这方面是薄弱的。

python爬虫应该怎样使用代理IP

第一步:找IP资源 IP资源并不丰富,换句话说是供不应求的,因此一般是使用动态IP。免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。付费方法,通过购买芝麻ip上的IP资源,并进行提取,搭建IP池。第二步,检测可用IP保存。

设计代理IP池的目的是为了方便管理和提高工作效率,特别是在进行网络爬虫操作时。 代理IP的获取可以通过两种方式:免费代理IP可以使用ProxyGetter接口从代理源网站抓取;而付费代理IP通常通过专门的API获取,注意API的使用限制,如提取数量和间隔时间。 存储代理IP时,推荐使用SSDB数据库。

Python爬虫一般使用代理IP来隐藏真实的IP地址,以防止被目标网站封禁或限制访问。这样可以有效地绕过网站的反爬取技术,并且可以实现高强度、高效率地爬取网页信息而不给网站服务器带来过大的压力。

获取提供代理IP的网站,提取一定数量的IP,然后验证这些IP是否可用,然后将这些IP保存供爬虫使用。因为免费的IP代理网站提供的IP可用性和稳定性较低,需要大量的抓取才能得到一些可用的IP。一般来说,代理IP是时间有效的。简单来说就是有有效期。有效期过后,代理IP将失效。

获取代理IP地址 在访问目标网站之前,我们需要从代理池服务器中获取一个可用的代理IP地址。具体来说,我们可以使用代理池服务器提供的“获取代理IP地址”API接口来实现。设置代理IP地址 在获取到代理IP地址之后,我们需要将其设置为网络爬虫的代理IP地址。

IP资源最好独享 独享IP能直接影响IP的可用率,独享http代理能确保每个IP同时只有一个用户在使用,能确保IP的可用率、稳定性。调用方便 对于爬虫工作者而言,调用API也是一个较为繁琐的过程,而部分较为优质的代理服务商往往有着丰富的API接口,方便集成到任何程序里,以便爬虫使用。

为什么爬虫需要代理ip?

在爬虫的时候,被爬网站是有反爬虫机制的,如果使用一个IP反复访问一个网页,就容易被出现IP限制,无法再对网站进行访问,这时就需要用到代理IP。爬虫在抓取一个网站数据的时候,就相当于反复向一个人打招呼,有非常大的几率会被拉黑。

综上所述,代理IP在网络爬虫中起着关键的作用,它可以帮助爬虫隐藏真实IP地址,避免IP被封锁,从而保证数据收集的顺利进行。在选择使用代理IP时,我们需要权衡稳定性和成本等因素,以选择最适合自己需求的代理IP服务。

IP池要大,众所周知,爬虫采集需要大量的IP,有的时候会每天需要几百万上千万的调用,如果IP数量不够,那爬虫的工作也无法进行下去。所以企业爬虫一般要找实测至少百万以上的IP,才能确保业务不受影响。

如何用爬虫爬网络代理服务器地址

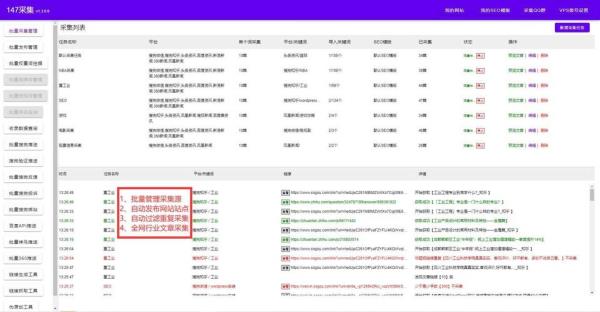

1、免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。付费方法,通过购买芝麻ip上的IP资源,并进行提取,搭建IP池。第二步,检测可用IP保存。提取到的IP,可以进一步进行检测是否可用,比如访问某个固定的网站,找出访问成功的IP进行保存。

2、获取代理IP地址 我们可以通过购买或免费获取代理IP地址。购买代理IP地址的好处是稳定性和速度都比较高,但是价格也相对较高。而免费获取代理IP地址则需要花费一定的时间和精力来筛选和测试,但是成本相对较低。搭建代理池服务器 我们可以使用Python语言来搭建代理池服务器。

3、八爪鱼采集器是一款功能全面、操作简单、适用范围广泛的互联网数据采集器,可以帮助您快速上手Python爬虫技巧。以下是一些Python爬虫上手技巧: 学习基础知识:了解Python的基本语法和常用库,如requests、BeautifulSoup、Scrapy等。 确定目标网站:选择您要爬取数据的目标网站,并了解其网页结构和数据分布。

4、基本步骤发现可读且可访问的URL。浏览种子或URL列表以识别新链接并将它们添加到列表中。索引所有已识别的链接。使所有索引链接保持最新。很多网站都具有反爬虫策略,常见的方式有:验证码、登陆、限制IP等。验证码。可以利用打码平台破解(如果硬上的话用opencv或keras训练图);登陆。

以上就是极光爬虫ip代理(极光代理ip破解版)的内容,你可能还会喜欢极光爬虫ip代理,爬虫代理,代理网站,服务器,拨号服务器等相关信息。